La ricerca scientifica pubblica in Italia versa da anni in gravi condizioni. Per salvarla serve un fronte ampio e compatto formato non solo da docenti e ricercatori, ma anche da studenti, laureati e precari, che intraprenda azioni concrete volte a sensibilizzare opinione pubblica e classe politica, per ottenere riforme urgenti e condivise. Questo blog vuole essere una piattaforma propositiva di aggregazione e informazione per chi si rifiuta di assistere in silenzio ad un tracollo annunciato.

domenica 14 settembre 2014

I mostri della VQR

I risultati della recente VQR 2004-2010, se da una parte hanno premiato strutture di ricerca di buono od ottimo livello, dall'altra hanno prodotto, come si temeva, diverse aberrazioni e risultati paradossali. Questi "mostri" della valutazione sono sotto gli occhi di tutti.

Se l'Università di Messina (con tutto il rispetto per i colleghi di quell'Ateneo) risulta migliore del Politecnico di Milano e la Normale di Pisa viene classificata come un'Università mediocre, significa che esistono dei seri problemi alla base del metodo valutativo ideato dall'ANVUR

http://www.roars.it/online/lo-strano-caso-della-normale-e-della-vqr/

E questi sono solo di due esempi clamorosi tra i tanti messi in evidenza finora. I sette saggi del consiglio direttivo dell'Anvur, che ci costa circa un milione e 200mila euro all'anno, dovrebbero fare una seria autocritica ed invece non mi risulta che si siano pronunciati o che stiano preparando dei correttivi.

Il fenomeno delle aberrazioni valutative però è molto serio, non può e non deve essere ignorato. Anomalie e casi paradossali sono stati segnalati altrove, anche nella Facoltà di Scienze della Sapienza di Roma. In particolare, il Dipartimento di Biologia e Biotecnologie "Charles Darwin" ha ottenuto sorprendentemente un piazzamento mediocre. E nel Dipartimento, anche settori di punta come la Genetica e la Biologia Molecolare hanno stranamente e inaspettatamente conseguito valutazioni non degne della loro fama. Qualcosa però non quadra, perché questi risultati sono in clamorosa contraddizione con quelli della precedente valutazione delle strutture di ricerca condotta dal CIVR per il periodo 2001-2003. In quel caso, infatti, il Dipartimento di Genetica e Biologia Molecolare, confluito a luglio 2010 nel nuovo Dipartimento di Biologia e Biotecnologie, aveva ottenuto un ottimo piazzamento. Risultati simili a quelli del CIVR erano stati ottenuti anche da un metodo in silico ideato dal collega Gianni Cesareni.

http://www.fisv.org/2013-09-04-15-46-07/attivita/item/234-valutazione-della-ricerca-gianni-cesareni-risponde-al-nostro-invito-con-un-suo-contributo.htmlIl metodo di Cesareni basato su Google Scholar è stato criticato anche da Roars, ma se ha prodotto risultati simili a quelli ottenuti dal CIVR che ha utilizzato il peer-review, forse meriterebbe un po' più di considerazione.

Come spiegare questa apparente défaillance della Genetica e della Biologia Molecolare, considerando che parliamo di settori da sempre molto produttivi anche alla Sapienza? Si tratta di settori "Jekill e Hyde", che da buoni si trasformano in cattivi?

1) Se si esaminano i dati, i punteggi negativi dovuti alla presenza di ricercatori inattivi hanno contato soprattutto per la Biologia Molecolare .

2) C'è stata poi una alta percentuale di “prodotti penalizzati”, ovvero inserimento di pubblicazioni non pertinenti da parte del gruppo pubblicazioni della Sapienza che ha operato la scelta. Per penalizzanti si intendono i prodotti non valutabili, i prodotti identici presentati più volte dalla stessa struttura, i prodotti identici presentati più volte dallo stesso soggetto valutato per due strutture di tipologia differente (es. Università ed Ente di Ricerca). C'è da capire come questo sia potuto accadere, visto che la scelta dei prodotti è stata effettuata dal gruppo pubblicazioni della Sapienza. Si tratta di un aspetto molto critico, che poco ha a che fare con la qualità della ricerca e che andrà necessariamente "curato" per evitare che si ripeta la prossima volta.

3)A parte i suddetti aspetti, un altro elemento determinante, il cosiddetto "baco" della VQR, come già evidenziato altrove, è insito nel metodo utilizzato. Infatti, il metodo valutativo del CIVR era basato sul peer-review, mentre quello della VQR utilizza sostanzialmente dei parametri bibliometrici automatici; il peer-review viene utilizzato solo marginalmente. I risultati finali vengono poi definiti in base a fattori di correzione scelti molto arbitrariamente.

I principali difetti del metodo automatico dell'ANVUR che generano aberrazioni valutative sono i seguenti:

1) Le strutture di ricerca o i settori si devono valutare in base alla loro produzione complessiva del periodo in esame. La richiesta di presentare solo i tre "migliori" lavori è un errore, perché può penalizzare Dipartimenti che hanno maggior produttività. E' vero che la quantità non significa necessariamente qualità, ma se si penalizzano le strutture per la presenza di docenti inattivi (che non hanno prodotti) o parzialmente attivi (che non arrivano a 3), allora bisognerebbe premiarle nel caso di docenti "iperattivi" ovvero che nel periodo di riferimento ottengono più di tre prodotti. C'è poi da sottolineare che la qualità degli articoli è funzione principale dalle citazioni ottenute e questo è un altro punto dolente

2) Alle citazioni, soprattutto per gli articoli pubblicati nel periodo 2004-2008, è stato attributo dall'Anvur un peso esageratamente determinante, come nel caso delle ASN. Al contrario, a livello internazionale, il numero di citazioni (come d'altrove tutta la bibliometria spicciola) non è ritenuto affatto una misura affidabile per valutare il merito e la qualità della ricerca e dei ricercatori. Questo è stato sottolineato più volte da diversi articoli pubblicati su Roars (vedi come esempio http://www.roars.it/online/uk-consultazione-pubblica-sugli-indicatori-quantitativi-per-la-valutazione-della-ricerca/) e anche su eccellenti riviste scientifiche internazionali. A tale riguardo consiglio di leggere l'articolo dei colleghi Adam Eyre-Walker e Nina Stoletzki pubblicato recentemente su PLOS BIOLOGY (vedi sotto).

Il peso delle citazioni è evidente se si consultano i "Quadrati Magici" dell'ANVUR, come li chiama Giuseppe De Nicolao.

Di conseguenza, può accadere che un articolo su PNAS o Science (classe A) venga retrocesso nelle categorie inferiori o addirittura non sia nemmeno considerato (come è successo al sottoscritto) per non aver ottenuto il numero minimo di citazioni previsto dall’Anvur. In compenso, sempre in base alle citazioni, un articolo su una rivista di categoria inferiore (B, C o D) può venire sopravvalutato. In questo modo, si appiattiscono le differenze o addirittura si rovesciano i valori in campo. E' possibile che la qualità di un articolo scientifico debba essere così pesantemente condizionata da questa sorta di audience, alla stregua di una trasmissione televisiva? Attribuendo alle citazioni un peso così determinante, questa VQR tende in molti casi a premiare con risorse immeritate i comportamenti opportunistici di colleghi "furbetti" che da sempre abusano delle autocitazioni. Vogliamo accettare questo "doping" della valutazione?

3) A parte i casi di eccesso di autocitazioni, le citazioni rappresentano comunque un parametro molto delicato: spesso possono essere anche negative e non sempre vengono assegnate così "democraticamente", come qualcuno vorrebbe farci credere. Come sottolineato nell'articolo di Adam Eyre-Walker e Nina Stoletzki, il fattore geografico, ad esempio, è sicuramente determinante. In particolare, per esperienza trentennale sul campo ho verificato che in certi settori come per l'appunto la Genetica e la Biologia Molecolare degli organismi modello, i ricercatori italiani che svolgono ricerca di base devono sostenere una fortissima competizione internazionale soprattutto con ricercatori di paesi abituati ad avere una notevole supremazia in campo scientifico, come Stati Uniti, Inghilterra e Germania. In virtù di questo, tendiamo spesso ad essere "snobbati" e sottovalutati anche in termini di citazioni. In soldoni, un nostro lavoro anche molto buono può non riscuotere successo in termini di citazioni.

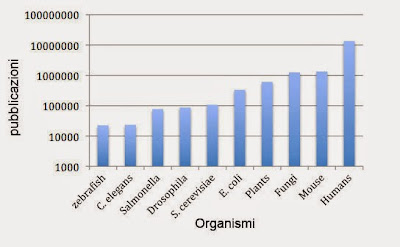

E' abbastanza ovvio, quindi, che una siffatta VQR tenda a privilegiare gruppi ampi e accademicamente forti che lavorano in campi di ricerca più gettonati ed in sistemi sperimentali più diffusi o più di moda anche nel nostro paese. Gruppi che pubblicano articoli con folte schiere di autori e hanno, anche per questo motivo, un livello fisiologico di citazioni molto più alto rispetto a gruppi che fanno ricerca di base. Questo si può verificare facendo un piccolo e banale esperimento: consultando pub med, si osserva che, ad esempio, gli articoli scientifici in campo umano sono circa 100-200 volte più numerosi di quelli sugli organismi modello come Drosophila e S. cerevisiae (vedi tabella sottostante). Di conseguenza, la maggior numerosità fa crescere anche il parametro citazionale ed il valore degli altri indicatori bibliometrici, indipendentemente dalla valore scientifico della pubblicazione. E questo è vero per tutte le aree di ricerca.

Perché i 7 saggi dell'ANVUR non hanno considerato questo aspetto così lapalissiano?Non volendo considerare la totale infermità mentale, per molti l'ipotesi più probabile è che i parametri della VQR (come per le ASN) siano il frutto di una scelta fatta ad hoc, ovvero siano quelli più favorevoli ai settori di appartenenza degli stessi 7 saggi. Per il futuro, allora, l'ANVUR farebbe prima a pubblicare direttamente la lista delle discipline scientifiche che intende privilegiare a priori, comunicando allo stesso tempo la definitiva cancellazione della ricerca di base nel nostro paese.

CONCLUSIONI

In base alle considerazioni fatte, è evidente che in molti casi i risultati ottenuti dalla recente VQR sono poco attendibili e non è corretto usarli per distribuire le risorse, premiando "i buoni" e punendo "i cattivi". Ma la cosa più grave è che in molte università, Sapienza compresa, i risultati della VQR sono presi da molti colleghi (quelli a cui conviene) come "oro colato", senza che sia stata aperta una riflessione seria su quelle che sono le evidenti disfunzioni del sistema. In conseguenza di ciò, per la distribuzione dei punti organico, nei dipartimenti penalizzati si è scatenata una bagarre tremenda, dove chi ha una VQR "migliore" si ritiene automaticamente al top dell'accademia!

Queste considerazioni riflettono il pensiero di molti altri colleghi che vorrebbero svegliarsi al più presto da questa specie di incubo in cui l'ANVUR li ha costretti a vivere. Visto che l'Anvur non sembra disposta a correre ai ripari per introdurre adeguati correttivi, a breve invieremo una lettera al Ministro di turno, all'Anvur, al CUN e anche alle riviste scientifiche per denunciare i "mostri" generati da questa VQR.

Speriamo ardentemente che i nuovi membri dei vari GEV riflettano su questa situazione per contribuire dall'interno a riformare il metodo della VQR, allo scopo di garantire un sistema di valutazione più equo che sappia realmente individuare la qualità, senza occultarla.

QUALE ANTIDOTO CONTRO I MOSTRI DELLA VQR?

Cosa fare per rendere più equo il sistema di valutazione? La valutazione della ricerca e dei ricercatori non può essere basata esclusivamente sul sistema bibliometrico quantitativo dell'ANVUR. La valutazione deve essere condotta usando modalità simili a quelle utilizzate in precedenza dal CIVR. Le pubblicazioni e i prodotti della ricerca devono essere valutati dai pari e non da un sistema automatico fatto di numeri, dividendi e fattori di correzione scelti ad hoc. La bibliometria deve essere usata con parsimonia, eventualmente come strumento accessorio.

Se questo non sarà possibile, per la prossima VQR auspichiamo almeno i seguenti correttivi:

1) Eliminare le autocitazioni

2) Ridefinire le categorie delle pubblicazioni e i loro livelli qualitativiAd esempio, non è possibile che nell'area 05 in categoria A siano presenti riviste con valori clamorosamente diversi di Impact Factor, come Science (IF 32) e Insect Molecular Biology (IF 2,9) perché quest'ultima risulta una delle migliori in un settore, ahimè, un po' depresso come l'Entomologia. Nessun ricercatore sano di mente potrebbe mai sostenere che pubblicare su Science o su Insect Molecular Biology sia la stessa cosa. Ma l'ANVUR invece si!!!

3) Ridurre o eliminare l'effetto delle citazioni sul valore di una pubblicazione

4) Ridurre il peso degli inattivi sulla valutazione finale, ad esempio considerando solo i docenti inattivi assunti nei 5 anni precedenti al periodo in esame.

5) Non considerare i cosiddetti "prodotti penalizzanti" che nulla hanno a che fare con la qualità scientifica di una struttura di ricerca, ma che pesano negativamente sulla valutazione.

6) Rapportare ogni settore alla media nazionale dell'area scientifica di appartenenza e non a quella del singolo settore. In altre parole, ad esempio nell'area 05 (Scienze Biologiche), ogni settore (Genetica, Microbiologia,Biologia Molecolare, Biologia Cellulare, Botanica, Zoologia, ecc) oppure ogni dipartimento, dovrebbe rapportare il valore della propria VQR a quello della media nazionale dell'area stessa.

In questo modo, molti dei mostri valutativi a cui abbiamo fatto riferimento verrebbero debellati o almeno addomesticati.

Last but not least: appurato che il sistema VQR è disfunzionale e produce errori di valutazione anche clamorosi, chi ripagherà i settori e i ricercatori penalizzati che si sono visti ingiustamente privare di risorse essenziali?

Iscriviti a:

Commenti sul post (Atom)

Nessun commento:

Posta un commento